如果说我看得比别人更远些,那是因为我站在巨人的肩膀上。

—— 牛顿

当谈论深度学习变成一件很酷的事情时,作为其子领域的自然语言处理(英文简称“NLP”)也逐渐被世人熟知,站到了人工智能大舞台的最前列。

上一期,我们借着深度学习三巨头获颁图灵奖的话题,讨论了深度学习技术的三大应用领域,特别是其中基于自然语言处理的金融科技应用更是誉存科技的核心能力与业务之一。

打铁还需自身硬。今天我们不说应用,只论这门技术的几个重点。文章基于誉存科技深度学习小组工作经验所撰,希望会对初入人工智能领域,想要了解NLP的同学有所帮助。

01 关于NLP的基本常识

在这里,笔者首先要向大家推荐一本NLP领域的经典教材《Speech and Language Processing 》,里面包含了 NLP 的基础知识、语言学扫盲知识、基本任务以及解决思路。阅读此书,你会接触到很多 NLP 的最基本任务和知识,比如 tagging, parsing,coreference, semantic role labeling 等等,这对于全局地了解 NLP 领域有着极其重要的意义。

为什么要推荐大家读这本书呢?因为不积跬步无以至千里。

以最近大热BERT为例,它是谷歌发布的开源自然语言处理模型,在问答系统、自然语言推理和释义检测(paraphrase detection)等任务中均取得了突破性的进展。尤其是训练 language model (LM)的随机替换更是刷新了各项NLP任务的成绩。那么,随机替换是什么?其本质就是语言建模里面基于 interpolation 的平滑方式,而基于 interpolation 的 LM 平滑,在本书中早有阐释。

02 为什么学NLP很重要?

众所周知,语言是人类智慧的伟大结晶,也是人与人之间沟通交流的基本手段,而机器作为异次元生物不能直接与人对话,需要特殊的传感器和字节符号,于是就产生了交流障碍。自然语言处理作为一种人工智能技术,能帮助机器识别人类语言,并分析、理解、改变或生成它,是打破人机交流屏障的重要技术手段。

从目前的趋势来看,人工智能是未来,其发展势不可挡。不必说从事互联网的人们已经制造出的海量数据/信息,未来还将持续,这大千世界还存在其他海量结构化、半结构化和非结构化数据。就线上的结构化数据而言,在大数据、云计算技术的通力整合下,其技术已基本成熟和稳定,而对于半结构化和非结构化数据的处理,因为涉及的复杂性,在当前和未来更多领域应用都具有极大的困难和挑战。

智能时代,不仅企业需要懂 NLP 技术的人来处理这些海量非结构化数据,研发人员也需要利用NLP技术轻松实现人机交互。从这点来看,NLP的重要性已不言而喻,而各大招聘网站上列出的NLP算法专家薪酬更是一个简单粗暴但在理的佐证。

03 经典NLP模型

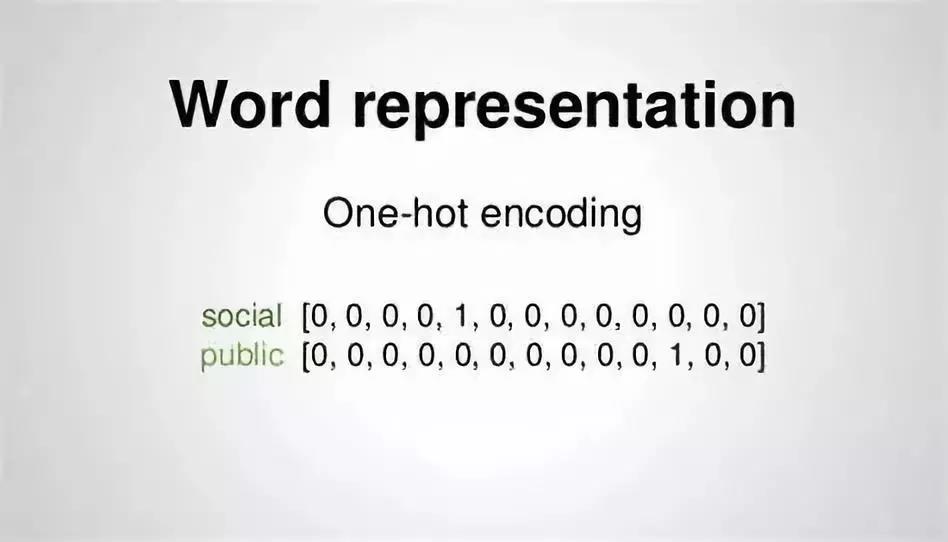

自然语言处理的第1步通常都是将输入的文字转成数字化。

NLP中最直观的文字表示方法是One-hot Representation. 这种方法把每个词表示为一个以词汇量为大小的向量。该向量中除了一个元素为1,其他都为0.

这种表示方法很简洁,但不能编码词与词之间的关系,因为任何两个词的词向量的的相似度都为0. Word Embedding (词嵌入) 可以将词表示从 One-hot Representation转成一个定长的、连续的稠密向量。之所以称为稠密,因为一个词经词嵌入之后,特征维度相对于原来的维度(也即是词汇表的大小)大为减小。词嵌入是语言模型的“副产品”。语言模型的基本思想是对出现在上下文环境里的词进行预测。词嵌入通过训练之后能够体现出词与词之间的关系。语言模型的训练属于非监督学习,故大规模训练语料(如wikipedia)很容易获得。

通过训练一个语言模型,得到词嵌入矩阵,再使用该矩阵作为输入训练其他NLP模型,这种思想在一定程度上对BERT模型的提出产生影响。

04 我们的应用

前面已提到过BERT模型在NLP任务中刷新了多项记录。

誉存科技深度学习小组也结合NLP最新研发成果与公司的实际业务需求,第一时间将BERT预训练模型运用到了文本分类、命名实体抽取、新闻情感分析、文本摘要、文本聚类和中英文翻译等方面,并取得了很好的成果。

下面简单介绍下这几个具体NLP任务的作用:

文本分类的目的是更加高效便捷找到用户关心的文本类型。

命名实体识别是抽取文本中人名、地名和机构名,有助于找到文本的主体以及主体的属性。

新闻情感分析是确定新闻内容所描述的情感倾向;不同的倾向意味着主体(个人或者公司)在经历好的、不好的或者中性的事件。

文本摘要的目的是化繁为简,将目标文档从一个长文本转成一个短文本(通常在100字以内),并尽量保持核心思想不变。

文本聚类是将讲述相同话题的新闻或者其他文档分门别类,有利于找出文档中不同事件的受关注程度。

中英文翻译则是将这两种语言的文档翻译成某一种语言,方便文档的阅读和理解。

BERT模型的强大之处就在于,它已经从数百万篇文章当中学习到了字与字、词与词之间的关系。这种能力为构建在BERT预训练模型之上的具体事务模型(如文本分类)提供了语境信息,使得事务模型在仅使用少量训练样本的情况下就能表现就好的效果。

最后,给大家一个小小的建议:多看关于NLP的论文,特别是子领域相关的一些研究成果,包括文本分类、实体识别、情感分析等等。另外,基本的数学逻辑也需要搞懂,毕竟天天都在用算法,无时无刻不在优化,数学太渣,会浪费很多时间的。

PS:本文部分图片来源于网络,如有侵权请联系删除。